Lernen - oder zunächsteinmal das Verhalten des Netzes verändern - können wir, indem wir an den Gewichten irgendwie drehen

7. Ziel des Lernens ist es, den Fehler zwischen dem Desired Output und dem tatsächlichen Output für alle Eingaben möglichst klein zu machen. Es gibt

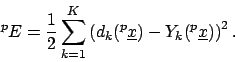

- den Fehler für ein Trainingsmuster: Der Fehler für ein Trainingsmuster

ist definiert als

ist definiert als

Um dieses Trainingsmuster zu lernen, stellen wir die Gewichte so ein, dass genau die richtige Ausgabe herauskommt. Das ist relativ einfach lösbar und funktioniert immer.

- den Fehler für alle Trainingsmuster zusammen: Dieser Fehler ist definiert als die Summe aller Fehler der Trainingsmuster

Wir möchten gerne für alle Beispiele zusammen die Gewichte so einstellen, dass immer die richtige Ausgabe herauskommt, wenn wir ein Beispiel anlegen. Das ist sehr viel schwieriger und vielleicht unlösbar8.

Was wir wollen ist allerdings, dass auch unbekannte Daten richtig klassifiziert werden. Dies ist ein schwieriges Problem der Neuronalen Netze. Unter gewissen Umständen lernen die Neuronalen Netze die Trainingsdaten auswendig. Auf unbekannten Daten versagen sie völlig. Wir möchten gerne eine

Generalisierung erreichen. Dazu später mehr.

ist definiert als

ist definiert als